Revista Literaria Ave Viajera Copy

EXPLICANDO LA INTELIGENCIA ARTIFICIAL SIMPLE Y LLANAMENTE

|

TODO TITULO SUBRAYADO ES VÍNCULO A LA PÁGINA CORRESPONDIENTE

Los Derechos de Autor de todos y cada uno de los autores publicados en este portal están protegidos por estatutos y registros editoriales internacionales. ©®

EXPLICANDO LA INTELIGENCIA ARTIFICIAL SIMPLE Y LLANAMENTE

"La ciencia se construye con hechos; de la misma manera que las casas están hechas de piedras, la ciencia está construida con hechos; pero un montón de piedras no son una casa y una colección de hechos no son necesariamente ciencia."Jules Henry Poincarè "La ciencia se construye con hechos; de la misma manera que las casas están hechas de piedras, la ciencia está construida con hechos; pero un montón de piedras no son una casa y una colección de hechos no son necesariamente ciencia." Jules Henry Poincarè Desde el final de la década del 2010 hemos venido escuchando hablar de manera cada vez más frecuente acerca del concepto de la inteligencia artificial: el ser humano podrá prontamente crear máquinas inteligentes que podrían desplazarlo académica y laboralmente. Una idea sorprendentemente aterradora, incluso apocalíptica, como en las películas de Terminator. La verdad es que, aunque es cierto que las máquinas podrían reemplazarnos, la inteligencia artificial no será más que eso inteligencia, no tendrá la capacidad de tener sentimientos o empatía, al menos por ahora. La conjetura de Poincaré es un problema matemático de la geometría multidimensional y por lo tanto de la teoría de conjuntos y de la estadística, que fue planteado en 1904 por el filósofo y matemático francés Jules Henry Poincaré, el reconocido autor de Hipótesis y Ciencia. La conjetura de Poincaré textualmente plantea: "Toda 3-variedad cerrada y simplemente conexa es homeomorfa a la 3-esfera". La conjetura de Poincaré fue considerada como uno de los 7 problemas matemáticos del milenio y finalmente fue resuelta en el año 2003 por el matemático ruso Grigori Perelman quien se basó en los trabajos previos de Richard Hamilton. Su resolución abrió el camino a los famosos algoritmos con los que funcionan las plataformas tecnológicas de las redes sociales y a la inteligencia artificial. Lejos de las teorías conspirativas entre las cuales se asegura que Amazon ya sabía que yo estaba escribiendo este editorial, y que Trump fue elegido por la intervención quirúrgica de Facebook y uno que otro ruso, las redes sociales y la inteligencia artificial tienen un sustento científico y matemático que intentaré explicar aquí. Personalmente creo que todos necesitamos aprender matemáticas, sobre todo los médicos, que escogimos la biología porque las matemáticas no nos gustaban o nos iba mal en ellas. Con el tiempo, he ido aprendiendo que el problema de los profesionales de las ciencias de la salud con las matemáticas tiene que ver mucho más con la mediocre formación en matemáticas que recibimos en el colegio, asunto que parece no haber cambiado mucho en tres o cuatro décadas dados los malos resultados que hoy obtienen nuestros bachilleres colombianos en las pruebas internacionales. Recordando que las máquinas hablan en lenguaje binario (ceros y unos, donde cero es sin corriente eléctrica y uno es con corriente eléctrica) en combinaciones para activar diferentes sectores o funciones dentro de un procesador, memoria, etc, de acuerdo a una programación realizada por el hombre, la inteligencia artificial necesita poder discernir la geometría de los datos que han sido almacenados en ella como ceros y unos y tener la capacidad de diferenciar entre geometrías "simplemente conexas o no conexas". Dicho de otra forma, geometrías conectadas o no conectadas; o de una manera aún más simple geometrías de planos completos o geometrías con agujeros. Una máquina tendría que poder responder a una orden simple: "cuidado con el hueco", y tendría que localizar el hueco y esquivarlo para evitar caer en él. Desde el punto de vista de inteligencia, recibir el comando verbal "cuidado con el hueco" es recibir una alerta específica, y requiere de múltiples acciones para identificar un hueco específico y poder esquivarlo. La diferenciación del hueco o agujero de una forma racional implica para una máquina crear un concepto "de novo" que es el del hueco o agujero delimitarlo geométricamente, y de acuerdo con esto, tomar las acciones pertinentes para esquivarlo. Identificar un hueco o agujero y delimitarlo geométricamente implica construir una imagen de un concepto abstracto (el hueco) y tomar decisiones para evitar caer en él. En inteligencia artificial esto corresponde a crear "de novo" una secuencia de ceros y unos que corresponda al hueco e insertarlos como código dentro de su propia programación para posteriormente poder recordar dónde está el hueco. Sin embargo, cuando el hueco sea cubierto la máquina deberá discernir que el hueco en efecto ha sido cubierto y tendrá que reescribir "de novo" un fragmento de código con la información que hacía referencia al hueco y a que fue cubierto y tendrá que replantear la acción a tomar: en vez de tomar un desvío, deberá pasar por sobre el hueco cubierto; pero deberá recordar el sitio donde estaba el hueco antes de ser cubierto. La matemática es una ciencia formal (conjunto sistemático de conocimientos racionales y coherentes), que a partir de axiomas (planteamientos verbales de problemas) y razonamiento lógico, se encarga de estudiar las relaciones y propiedades entre entidades abstractas (números, figuras geométricas, símbolos, etc) para plantear problemas de manera no ambigua en contextos específicos, que ha sido ampliamente definida como el lenguaje que se debe utilizar en la ciencia. Como la matemática define a la geometría y la geometría a la estadística, a la física, al universo mismo entre otros, y los comprueba, la conjetura de Poincaré estuvo en el centro del conocimiento humano por descubrir y sin resolución durante prácticamente un siglo. La conjetura de Poincaré es un problema de geometría del cual se encarga la topología. La topología es una parte de las matemáticas que se encarga del estudio de las propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. Una manera simplista pero fácil para ilustrar el concepto es decir qué es la ciencia que estudia las propiedades geométricas de una plastilina en las manos de un niño. Mientras la plastilina no sea separada, pegada o agujereada, su geometría de dos dimensiones podrá cambiar mediante compresión o tensión, pero seguirá siendo un mismo conjunto geométrico y por lo tanto la resolución matemática de la geometría de esa plastilina seguirá siendo esencialmente la misma. A manera de broma, se suele decir que un topólogo no es capaz de discernir la diferencia entre una taza y un donut, porque desde el punto de vista topológico, geométricamente serían lo mismo. Al tener una taza y un donut un agujero, la una podría transformarse en la otra si ambas fueran de plastilina, comprimiéndose y estirándose alrededor del agujero. De acuerdo con esto una pelota de plastilina podría convertirse en un frisbee al comprimirse y estirarse, pero no podría convertirse en un donut porque la pelota no tiene agujero. No tener agujero significa que la pelota es simplemente conexa. La única estructura de 2-variedad simplemente conexa que existe es la esfera. La esfera que vemos y percibimos ha sido definida como una 2-esfera o esfera 2-variedad. La esfera 1-variedad o 1-esfera sería un círculo sin volumen dibujado en un papel. Sin embargo, matemáticamente existen n-esferas. Es decir, esferas que nuestros ojos no pueden ver pero que nuestro conocimiento matemático puede inferir. Hasta aquí hemos definido los conceptos necesarios para entender la primera parte de la conjetura de Poincaré; "Toda 3-variedad cerrada y simplemente conexa".Para la segunda parte de la conjetura: "es homeomorfa a la 3-esfera", es necesario entender el concepto matemático de homeomorfismo. matemáticas el homeomorfismo se define mediante funciones biyectivas continuas con inversas continuas. Una función es biyectiva, sí y solo si esta es inyectiva y sobreyectiva al mismo tiempo. Se le conoce como función inyectiva al vinculo que se desarrolla entre dos conjuntos, a través del cual a cada elemento de un conjunto se le asigna un elemento del otro conjunto o ninguno. Se conoce como función sobreyectiva a un conjunto de pares ordenados en el cual el primer elemento de cada par no se repite. Dicho de otra forma, esto ocurre cuando todos los elementos del conjunto de salida tienen una representación diferente en el conjunto de llegada y a cada uno de los elementos del conjunto de llegada le corresponde uno de los elementos del conjunto de salida. Cuando esto ocurre en términos geométricos o espaciales de manera continua y con inversas continuas se habla de homeomorfismo. Imaginemos por un momento que en el conjunto A se encuentran las adivinanzas y en el conjunto B se encuentran las respuestas a las adivinanzas. Entonces, en el conjunto A tendremos el elemento 1: agua pasó por aquí, cate que yo no la vi; y el elemento 2: blanco, redondo, gallina lo pone y frito se come. En el conjunto B tendremos el elemento 1: aguacate; y el elemento 2: Huevo. Cada uno de los elementos de cada conjunto (A y B) están representados por un elemento homeomorfo en el otro conjunto. Son homeomorfos porque las representaciones conceptuales son inyectivas y sobreyectivas al mismo tiempo y siempre serán continuas con inversas continuas.

|

Una pelota es un ejemplo de una esfera de dimensión 2 (una 2-esfera) o una esfera 2-variedad. Si pensamos en la 2 esfera como un conjunto, su contenido tendrá elementos con características específicas para haber sido agrupados dentro del mismo conjunto. Un ejemplo de esto es el afamado grupo de Facebook "yo también me fracturé el calcáneo". Desde el año 2006 hasta la fecha en este grupo hay 915 pacientes que tuvieron una fractura de calcáneo con un pobre resultado después de su tratamiento, haya sido este quirúrgico o no quirúrgico. Por definición este es un conjunto de personas con una característica que los define (fractura de calcáneo), que tiene una geometría que de acuerdo con la probabilidad nos define que después del tratamiento el resultado fue pobre o malo. Por otro lado, en ese mismo tiempo se han publicado cerca de 700 pacientes en diferentes estudios con fractura de calcáneo que igualmente fueron manejados de manera quirúrgica o no quirúrgica con resultados entre aceptables y buenos. Este es un conjunto de personas con una característica que los define (fractura de calcáneo), que tiene una geometría que de acuerdo con la probabilidad nos define que después del tratamiento el resultado fue bueno o excelente. La pregunta del millón es si estos dos conjuntos de personas con la misma característica que los define (fractura de calcáneo) tienen en realidad la misma geometría o diferente geometría. Podría ocurrir que sean dos representaciones geométricas de la misma plastilina que ha sido deformada en el caso del grupo de Facebook por la expectativa de los pacientes y la escala análoga visual del dolor, mientras que en el caso de los reportados en los artículos científicos la deformación geométrica pudo haber ocurrido a expensas del valor del resultado de la escala AOFAS de retro-pie. Eso significaría que teniendo la misma geometría esta haya sido deformada por la forma o manera de valoración clínica. En el caso de los pacientes en facebook la geometría podría ser la de una pelota (valoración subjetiva pero real), y en el caso de los investigadores la de un frisbee (valoración objetiva pero irreal). Pero también podría ocurrir que el grupo en Facebook no sea simplemente conexo y corresponda a una geometría con un agujero mientras que el grupo de pacientes reportados científicamente sea una esfera (sin agujero) y por lo tanto ambos grupos tendrían una geometría diferente y por lo tanto serían diferentes. Para resolver esto, habría que recurrir a la 2 ley de la termodinámica descrita por Albert Einstein en 1907: la "Entropía" también conocida como "mecánica estadística", como originalmente fue descrita por Ludwig Boltzmann entre 1890 y 1900, sin aplicación práctica. La entropía es la estadística del desorden, define de una manera simple la mayor probabilidad de equilibrio dentro de un sistema (termo-dinámico de acuerdo con la aplicabilidad que le dio Einstein) que a priori aparenta caos o desorden. El ejemplo más frecuentemente utilizado para explicar la Entropía es el de los dados: al lanzar un dado, si no se realiza trampa, la probabilidad de acertar el resultado es igual para cada uno de los números marcados en cada una de sus seis caras (16,66%); sin embargo, si se lanzan dos dados, la probabilidad de obtener un resultado no se reduce a 8.33% porque son dos dados, en razón de las posibles combinaciones que se podrían obtener: primero que todo solo se pueden obtener 11 posibles resultados (números del 2 al 12), en segundo lugar hay que considerar las posibles combinaciones que cada resultado podría tener. Por ejemplo, para obtener un 2 solo sería posible la combinación de 1+1, para obtener un tres podrían combinarse 1+2 y 2+1, para obtener un cuatro podrían combinarse 1+3, 2+2, y 3+1, y así sucesivamente. Pero, el resultado con mayor posibilidad de combinaciones sería el 7, así que, por entropía, podríamos decir que la mayor probabilidad de resultado sería 7. Este sistema de probabilidad es por el cual algunos jugadores de casino deben visitarnos a los ortopedistas después de amañar el juego en el casino, y por lo cual el casino usualmente cambia de manera regular los dados en la mesa de juego. De acuerdo con la entropía todo en el universo, aunque parezca desordenado tiene en realidad un orden. Por lo tanto, una inteligencia artificial tendrá necesariamente que identificar patrones probabilísticos en geometrías simplemente conexas y diferenciarlos de aquellos en geometrías no conexas. Eso en últimas es lo que hace nuestro cerebro con un gran margen de error a través del proceso al que llamamos experiencia. Con nuestra experiencia, somos capaces de llenar agujeros de conocimiento convirtiendo geometrías no conexas en simplemente conexas, motivados por nuestras emociones, lo cual es un error garrafal porque deducimos mal. Por entropía podemos algunas veces deducir bien, pero como nuestro cerebro percibe, pero no registra matemáticamente, estamos en desventaja frente a una máquina que logre pensar matemáticamente. Eso es lo que nos aterra. Claro, como el jugador de dados, podemos apostarlo todo a una idea que eventualmente resuelva algo, pero no necesariamente de la manera correcta. La máquina en cambio metódicamente irá generando pequeñas resoluciones a problemas específicos y seguirá analizando sus datos una y otra y otra vez, perfeccionándose a sí misma. El problema con la inteligencia artificial no es la máquina, somos nosotros como sus creadores, y administradores y lo generamos cuando no construimos adecuadamente un sistema de valores, reglas o límites que se deben o no cruzar. Si la inteligencia artificial es alimentada con valores reglas y límites seguramente contribuirá al progreso del ser humano como especie. Si los valores reglas y límites no están claramente definidos para la máquina, entonces estaremos creando un monstruo. Amanecerá y veremos cómo salen los experimentos de la inteligencia artificial en Escandinavia y cómo en otro lugares del mundo- Por ahora, al menos usemos este conocimiento para ser un poco más críticos en la diaria discusión mundial acerca de Uber.

fuente de información, la Entropía y La inteligencia Artificial

Fuentes de referencia. Wilkipedia, Google, La Teoria de Poincaré |

EXPLICANDO LA INTELIGENCIA ARTIFICIAL SIMPLE Y LLANAMENTE

Geoffrey Hinton es un informático

británico. Hinton fue galardonado con el Premio Turing en 2018 junto con Yoshua Bengio y Yann LeCun por su trabajo

en aprendizaje profundo.Nacimiento: 6 de diciembre de 1947 (edad 75 años), Wimbledon, Londres, Reino Unido Premios: Premio Turing, MÁS Educación: Universidad de Edimburgo (1972-1975), King's College, Cambridge (1967-1970), School of Informatics Padres: H. E. Hinton, Margaret Clark

|

La inteligencia

artificial. no simplemente como una tecnología sino como una forma de vida. En la era de ChatGPT**, Bard y similares,

nos enfrentamos a la pregunta de qué nos depara el futuro. Según los expertos, A.I. elevará nuestra sociedad

a un nivel superior o destruirá la civilización tal como la conocemos. Nos dará poderes divinos o nos

hará insignificantes e irrelevantes. Está ridículamente sobrevalorado, salvo que todavía no hemos

comprendido la magnitud de su importancia. En medio de certezas contradictorias, ¿tal vez sea necesaria algo de humildad? **ChatGPT Spanish (Español) proporciona el ChatGPT de OpenAI, que está construido

sobre el GPT-model 4 (GPT-4), que permite las comunicaciones e ntre el hombre

y los medios.

.

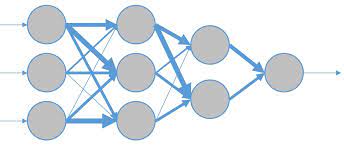

Debido a que las redes neuronales artificiales sólo tuvieron un éxito moderado en las tareas que emprendieron (categorización de imágenes, reconocimiento de voz, etc.), la mayoría de los investigadores las consideraron, en el mejor de los casos, medianamente interesantes o, en el peor, una pérdida de tiempo. "Nuestras redes neuronales simplemente no podían hacer nada mejor que un niño", recordó Hinton. En los años ochenta, cuando vio Terminador, no le molestó que Skynet, que la IA destructora del mundo de la película, fuera una red neuronal; Le complació ver que la tecnología se presentaba prometedora. Desde la pequeña depresión donde había estado el fuego, las grietas en la piedra, creadas por el calor, irradiaban hacia afuera. Hinton, que es alto, delgado y muy inglés, tocó el lugar con su bastón. Científico de principio a fin, siempre está comentando lo que sucede en el mundo físico: la vida de los animales, el flujo de las corrientes en la bahía, la geología de la isla. "Puse una malla de barras de refuerzo debajo de la madera, para que el aire pudiera entrar, y se calentó lo suficiente como para que el metal se ablandara", dijo, en un tono de asombro. "Es un incendio real, ¡ algo de lo que estar orgullosos !" Durante décadas, Hinton experimentó y construyó redes neuronales más grandes estructuradas de maneras ingeniosas. Imaginó nuevos métodos para entrenarlos y ayudarlos a mejorar. Reclutó estudiantes de posgrado y los convenció de que las redes neuronales no eran una causa perdida. Se consideraba parte de un proyecto que podría hacerse realidad dentro de un siglo, después de su muerte. Mientras tanto, quedó viudo y crio solo a dos hijos pequeños. Durante un período particularmente difícil, cuando las exigencias de la vida familiar y la investigación lo abrumaron, pensó que había contribuido todo lo que podía. "Estaba muerto en el agua a los cuarenta y seis años", dijo. No anticipó la velocidad con la que, hace aproximadamente una década, la tecnología de redes neuronales mejoraría repentinamente. Las computadoras se hicieron más rápidas y las redes neuronales, aprovechando los datos disponibles en Internet, comenzaron a transcribir el habla, jugar, traducir idiomas e incluso conducir automóviles. Cuando se adquirió la empresa de Hinton, un A.I, comenzó el auge que llevó a la creación de sistemas como Chat GPT de Open AI y Bard de Google, que muchos creen que están empezando a cambiar el mundo de maneras impredecibles. Hinton se dirigió a lo largo de la orilla y yo lo seguí, mientras la roca fracturada se movía debajo de mí. "Ahora mira esto", dijo. Se paró frente a una roca grumosa del tamaño de una persona que bloqueaba nuestro camino. "Así es como se transmite. Lanzas tu bastón"-arrojó el suyo al otro lado de la roca-"y luego hallas puntos de apoyo aquí y aquí, y un asidero allá" . Lo observé mientras trepaba con familiaridad y luego, más tentativamente, yo mismo di los mismos pasos. Rodeamos la costa hasta llegar ala cabaña de Hinton, la única en la isla. Estaba acristalada y una escalera se alzaba sobre pilotes de rocas anchas y oscuras. " Cada vez que aprendemos algo, nuestras redes de neuronas cambian, pero ¿cómo exactamente? Investigadores como Hinton, trabajando con computadoras, buscaron descubrir "algoritmos de aprendizaje" para redes neuronales, procedimientos mediante los cuales los "pesos" estadísticos de las conexiones entre neuronas artificiales podrían cambiar para asimilar nuevos conocimientos. en los años sesenta y setenta, Hinton dibujó redes de neuronas en cuadernos e imaginó nuevos conocimientos llegando a sus fronteras. ¿Cómo almacenaría un concepto una red de unos cientos de neuronas artificiales? ¿Cómo revisaría ese concepto si resultara ser defectuoso? |

|

A principios de este año, Hinton dejó

Google, donde había trabajado desde la adquisición. Estaba preocupado por el potencial de la A.I.de hacer daño

y comenzó a dar entrevistas en las que hablaba de la "amenaza existencial" que la tecnología podría

suponer para la especie humana. Cuanto más usaba Chat GPT, un A.I. más aprendía sobre el sistema en

un vasto corpus de escritura humana, y más incómodo se sentía.

Hay muchas razones para preocuparse por la llegada de la inteligencia artificial. Es de sentido común preocuparse de que los trabajadores humanos sean reemplazados por computadoras, por ejemplo. Pero Hinton se ha unido a muchos tecnólogos destacados, incluido Sam Altman, director ejecutivo de la empresa. de Open AI, al advertir que con A. los sistemas pueden empezar a pensar por sí mismos e incluso intentar apoderarse de la civilización humana o eliminarla. Fue sorprendente escuchar a uno de los investigadores más destacados de la IA expresar una visión tan alarmante. "La gente dice que es simplemente un autocompletado glorioso", me dijo, de pie en su cocina. Suponga que quiere ser realmente bueno prediciendo la siguiente palabra. Esa es la única manera. Entonces, al educar algo para que sea realmente bueno en la predicción de la siguiente palabra, en realidad lo estás obligando a comprender. Sí, es "autocompletado", pero no pensaste en lo que significa tener un autocompletado realmente bueno". Hinton cree que los "grandes modelos de lenguaje", como GPT, Generative Pretrained Transformer, un modelo de lenguaje desarrollado por Open AI que ha sido entrenado en una gran cantidad de texto en internet para responder a preguntas y generar texto de manera autónoma que impulsa los chatbots de Open AI; pueden comprender los significados de palabras e ideas. Señalemos que hay muchas cosas que separan la mente humana de las redes neuronales. Por un lado, las redes neuronales no aprenden como lo hacemos nosotros: adquirimos conocimiento de manera orgánica, al tener experiencias y captar su relación con la realidad y con nosotros mismos, mientras que ellas aprenden de manera abstracta, procesando enormes depósitos de información sobre un mundo que no aprenden. Realmente no habitamos. Pero Hinton sostiene que la inteligencia mostrada por A.I, los sistemas trascienden sus orígenes artificiales. "Cuando comes, tomas la comida y la descompones en estos

pequeños componentes", me dijo. "Entonces se podría decir que los pedazos de mi cuerpo están

hechos de pedazos de otros cuerpos. Pero eso sería muy engañoso". Él cree que, al analizar la escritura

humana, un modelo de lenguaje grande como GPT aprende cómo funciona el mundo, produciendo un sistema capaz de pensar;

escribir es sólo una parte de lo que ese sistema puede hacer. "Es muy hermoso", dijo en voz baja. "Y

entiendes el punto. De acuerdo al filosofo Bernard Williams, quien resultó estar interesado en las computadoras y la mente, esto es bastante diferente a la situación dentro de una computadora, en la que el software era independiente del hardware. A Hinton le sorprendió esta observación; Recordó cómo, en la escuela secundaria, un amigo le había dicho que la memoria podía almacenarse en el cerebro de forma "holográfica", es decir, distribuida, pero de tal manera que se podía acceder al todo a través de cualquier parte. Lo que estaba encontrando era el "conexionismo", un enfoque que combinaba neurociencia, matemáticas, filosofía y programación para explorar cómo las neuronas podían trabajar juntas para "pensar". Uno de los objetivos del conexionismo era crear un sistema similar al cerebro en una computadora. Se habían producido algunos avances: el Perceptrón, una máquina construida en los años cincuenta por un psicólogo y conexionista pionero llamado Frank Rosenblatt, había utilizado un hardware informático sencillo para simular una red de cientos de neuronas. Cuando se conectaba a un sensor de luz, el aparato podía reconocer letras y formas rastreando qué neuronas artificiales se activaban por diferentes patrones de luz Es útil para la mente etiquetar las cosas; les ayuda a comprender la realidad. Pero ¿qué significaría para una mente artificial hacerlo? Mientras Hinton obtenía un doctorado. Doctor en inteligencia artificial por la Universidad de Edimburgo, pensó en cómo se podría simular en una computadora el "saber" del cerebro. En aquella época, en la década de 1970, la gran mayoría de los investigadores de A.I. Los investigadores eran "simbolistas". En su opinión, conocer, por ejemplo, el ketchup podría implicar una serie de conceptos, como "alimento", "salsa", "condimento", "dulce", "umami", "rojo", "tomate", "americano", "Papas fritas", "mayonesa" y "mostaza"; juntos, podrían crear un andamio sobre el cual se podría colgar un nuevo concepto como "ketchup". Una gran y bien financiada A.I. El esfuerzo llamado Cyc se centró en la construcción de un vasto depósito de conocimientos en el que los científicos, utilizando un lenguaje especial, podían introducir conceptos, hechos y reglas, junto con sus inevitables excepciones pero no los pingüinos ni los pájaros con las alas dañadas o...) Pero Hinton dudaba de este enfoque. Parecía demasiado rígido y demasiado centrado en las habilidades de razonamiento que poseían los filósofos y lingüistas. Sabía que en la naturaleza muchos animales actuaban inteligentemente sin acceso a conceptos que pudieran expresarse con palabras. Simplemente aprendieron a ser inteligentes a través de la experiencia. El aprendizaje, no el conocimiento, era el motor de la inteligencia. El pensamiento humano sofisticado a menudo parecía ocurrir a través de símbolos y palabras. Pero Hinton y sus colaboradores, James L. McClelland y David Rumelhart, creían que gran parte de la acción ocurrió en un nivel subconceptual. Observen, escribieron, cómo "si aprendes un hecho nuevo sobre un objeto, tus expectativas sobre otros objetos similares tienden a cambiar": si te dicen que a los chimpancés les gustan las cebollas, por ejemplo, podrías adivinar que a los gorilas les gustan, también. Esto sugería que el conocimiento probablemente estaba "distribuido" en la mente, creado a partir de bloques de construcción más pequeños que podían compartirse entre ideas relacionadas. No habría dos redes neuronales separadas para los conceptos "chimpancé" y "gorila"; en cambio, haces de neuronas que representan varias "características" concretas o abstractas (pelaje, cuadrúpedo, primacía, animalidad, inteligencia, salvajismo, etc.) podrían activarse de una manera para significar "chimpancé" y de una manera ligeramente diferente para significar " gorila." A esta nube de características se le podría sumar el gusto por la cebolla. Una mente construida de esta manera corría el riesgo de caer en la confusión y el error: si se mezclan cualidades en la disposición incorrecta, se obtendría una criatura de fantasía que no era ni gorila ni chimpancé. Pero un cerebro con el algoritmo de aprendizaje correcto podría ajustar los pesos entre sus neuronas para favorecer combinaciones sensatas sobre las incoherentes. |

Hinton continuó explorando estas ideas, primero en la Universidad de California, San Diego, donde realizó un posdoctorado (y se casó con Joanne, a quien dio clases de visión por computadora); luego en Cambridge, donde trabajó como investigador en psicología aplicada; y luego en Carnegie Mellon, en Pittsburgh, donde se convirtió en profesor de informática en 1982. Allí gastó gran parte de su presupuesto de investigación en una única computadora lo suficientemente potente como para ejecutar una red neuronal. Pronto se casó por segunda vez con Rosalind Zalin, una bióloga molecular. En Carnegie Mellon, Hinton logró un gran avance. Trabajando con Terrence Sejnowski, informático y neurocientífico, produjo una red neuronal llamada Máquina Boltzmann. El sistema recibió su nombre de Ludwig Boltzmann, el físico austriaco del siglo XIX que describió, matemáticamente, cómo el comportamiento a gran escala de los gases se relacionaba con el comportamiento a pequeña escala de sus partículas constituyentes. Hinton y Sejnowski combinaron estas ecuaciones con una teoría del aprendizaje.

Hinton se mostró reacio a explicarme la máquina Boltzmann. "Les diré cómo es esto", dijo. "Es como tener un niño pequeño y decides salir a caminar. Y hay una montaña delante de ti, y tienes que llevar a este niño pequeño a la cima de la montaña y regresar". Me miró (al niño de la metáfora) y suspiró. Le preocupaba, con razón, que una explicación simplificada pudiera engañarme y luego engañar a otros. "No sirve de nada intentar explicar ideas complicadas que no entiendes. Primero, debes entender cómo funciona algo. De lo contrario, sólo producirás tonterías". Finalmente, tomó algunas hojas de papel y comenzó a dibujar diagramas de neuronas conectadas por flechas y a escribir ecuaciones, que intenté seguir. (Antes de mi visita, había realizado un curso de álgebra lineal en la Khan Academy). Una forma de entender la máquina Boltzmann, sugirió, era imaginar un Identi-Kit: un sistema a través del cual se pueden identificar varias características de una cara (cejas pobladas, ojos azules, narices torcidas, labios finos, orejas grandes, etc.). combinados para producir un boceto compuesto, del tipo utilizado por la policía. Para que un Identi-Kit funcione, las funciones mismas deben estar diseñadas adecuadamente. La máquina Boltzmann podría aprender no sólo a ensamblar las características sino también a diseñarlas, alterando los pesos de las conexiones entre sus neuronas artificiales. Comenzaría con características aleatorias que parecían nieve en una pantalla de televisión y luego procedería en dos fases -"despertar" y "dormir"- para refinarlas. Mientras está despierto, modificaría los rasgos para que se ajusten mejor a un rostro real. Mientras dormía, fantaseaba con un rostro que no existía y luego alteraba los rasgos para que encajaran peor. Sus sueños le dijeron lo que no debía aprender. El sistema tenía cierta elegancia: con el tiempo, podía alejarse del error y acercarse a la realidad, y nadie tenía que decirle si estaba bien o mal; sólo necesitaba ver lo que existía y soñar con lo que existía. Hinton y Sejnowski describieron la máquina Boltzmann en un artículo de 1983.

"Leí ese artículo cuando estaba comenzando mis estudios de posgrado y dije: 'Tengo que hablar con estos

muchachos; son las únicas personas en el mundo que entienden que necesitamos algoritmos de aprendizaje'", me dijo

Yann LeCun. . A mediados de los años ochenta, Yoshua Bengio, un pionero en el procesamiento del lenguaje natural y

en la visión por computadora y ahora director científico de Mila, un experto en inteligencia artificial. Instituto

de Quebec, entrenó una máquina Boltzmann para reconocer sílabas habladas como parte de su tesis de maestría.

"Geoff fue uno de los revisores externos", recordó. "Y escribió algo como 'Esto no debería

funcionar'". La versión de Bengio de la máquina Boltzmann fue más efectiva de lo que Hinton esperaba;

Bengio tardó algunos años en descubrir por qué. Esto se convertiría en un patrón familiar.

En las décadas siguientes, las redes neuronales a menudo funcionaban mejor de lo esperado, tal vez porque se habían

formado nuevas estructuras entre las neuronas durante el entrenamiento. "La parte experimental del trabajo vino antes

que la teoría", recuerda Bengio. A menudo se trataba de probar nuevos enfoques y ver qué se les ocurría

a las redes. Había muchas maneras en que el proceso de aprendizaje podía salir mal. En el "sobreajuste", por ejemplo, una red memorizó efectivamente los datos de entrenamiento en lugar de aprender a generalizar a partir de ellos. Evitar los diversos obstáculos no siempre fue sencillo, porque le correspondía a la red aprender. Fue como talar un árbol: los investigadores podían hacer cortes aquí y allá, pero luego tenían que dejar que el proceso se desarrollara. Podrían probar técnicas como "ensamblar" (combinar redes débiles para crear una fuerte) o "detener temprano" (dejar que una red aprenda, pero no demasiado). Podrían "preentrenar" un sistema tomando una máquina de Boltzmann, haciéndola aprender algo y luego colocando una red de respaldo encima de ella, de modo que el entrenamiento "supervisado" de un sistema no comenzara hasta que hubiera adquirido algo de elemental. conocimiento por sí solo. Luego dejarían que la red aprendiera, con la esperanza de que aterrizara donde querían.

|

|

Se desarrollaron nuevas "arquitecturas" de

redes neuronales: las redes "recurrentes" y "convolucionales" permitieron que los sistemas progresaran

basándose en su propio trabajo de diferentes maneras. Pero era como si los investigadores hubieran descubierto una

tecnología alienígena que no sabían cómo utilizar. Giraron el cubo de Rubik de un lado a otro,

tratando de poner orden en el ruido. "Siempre estuve convencido de que no era una tontería", dijo Hinton.

"No fue realmente fe; simplemente era completamente obvio para mí". El cerebro utilizó neuronas para

aprender; por lo tanto, debe ser posible un aprendizaje complejo a través de redes neuronales. Trabajaría el

doble de duro durante el doble de tiempo.

Cuando las redes se entrenaban mediante backprop, era necesario decirles cuándo se habían equivocado y en qué medida; Esto requirió grandes cantidades de datos etiquetados con precisión, lo que permitiría a las redes ver la diferencia entre un "7" y un "1" escrito a mano, o entre un golden retriever y un setter rojo. Pero fue difícil encontrar conjuntos de datos bien etiquetados que fueran lo suficientemente grandes, y construir más fue una tarea ardua. LeCun y sus colaboradores desarrollaron una base de datos gigante de números escritos a mano, que luego utilizaron para entrenar redes que pudieran leer códigos postales de muestra proporcionados por el Servicio Postal de EE. UU. Un científico informático llamado Fei Fei Li, de Stanford, encabezó un esfuerzo gigantesco llamado ImageNet; crearlo requirió recopilar más de catorce millones de imágenes y clasificarlas a mano en veinte mil categorías. A medida que las redes neuronales crecían, Hinton ideó una manera de transferir conocimiento de una red grande a una más pequeña que pudiera ejecutarse en un dispositivo como un teléfono móvil. "Se llama destilación", explicó en su cocina. "En la escuela, el profesor de arte nos mostraba algunas diapositivas y decía: 'Ese es un Rubens, ese es un Van Gogh y este es William Blake'. Pero supongamos que el profesor de arte te dice: 'Está bien, este es un Tiziano'. , pero es un Tiziano peculiar porque algunos aspectos se parecen bastante a Rafael, lo cual es muy inusual para un Tiziano.' Eso es mucho más útil. No sólo te están diciendo la respuesta correcta, sino que te están diciendo otras respuestas plausibles". En el aprendizaje por destilación, una red neuronal proporciona a otra no sólo respuestas correctas sino también una variedad de respuestas posibles y sus probabilidades. Era un tipo de conocimiento más rico. Unos años después de la muerte de Rosalind, Hinton se volvió a conectar con Jacqueline Ford, una historiadora del arte con quien había salido brevemente antes de mudarse a los Estados Unidos. Jackie era culta, cálida, curiosa y hermosa. "Ella está fuera de tu alcance", dijo su hermana. Aún así, Jackie dejó su trabajo en el Reino Unido para mudarse a Toronto. Se casaron el 6 de diciembre de 1997, el quincuagésimo cumpleaños de Hinton. Las siguientes décadas serían las más felices de su vida. Su familia estaba completa otra vez. Sus hijos amaban a su nueva madre. Él y Jackie comenzaron a explorar las islas de Georgian Bay. Recordando ese momento, miró la canoa en su sala de estar. "Lo encontramos en el bosque, boca abajo, cubierto de lona, y estaba totalmente podrido; todo estaba podrido", dijo. "Pero Jackie decidió rescatarlo de todos modos, como lo hizo conmigo y con los niños". Hinton no estaba enamorado de la retropropagación. "Es intelectualmente muy insatisfactorio", me dijo. A diferencia de la máquina de Boltzmann, "todo es determinista. Desafortunadamente, simplemente funciona mejor". Poco a poco, a medida que se fueron acumulando los avances prácticos, el poder del backprop se volvió innegable. A principios de los años setenta, me dijo Hinton, el gobierno británico había contratado a un matemático llamado James Lighthill para determinar si la I.A. la investigación tenía alguna posibilidad plausible de éxito. Lighthill concluyó que no era así, "y tenía razón", dijo Hinton, "si se aceptaba la suposición, que todo el mundo hacía, de que las computadoras podrían ser mil veces más rápidas, pero no mil millones de veces más rápidas". Hinton hizo un cálculo mental. Supongamos que en 1985 hubiera comenzado a ejecutar un programa en una computadora de investigación rápida y lo hubiera dejado ejecutándose hasta ahora. Si comenzara a ejecutar el mismo programa hoy, en los sistemas más rápidos utilizados actualmente en IA, le tomaría menos de un segundo alcanzarlo. A principios del siglo XXI, cuando las redes neuronales multicapa equipadas con potentes ordenadores empezaron a entrenarse con conjuntos de datos mucho más grandes, Hinton, Bengio y LeCun empezaron a hablar del potencial del "aprendizaje profundo". El trabajo cruzó un umbral en 2012, cuando Hinton, Alex Krizhevsky e Ilya Sutskever crearon AlexNet, una red neuronal de ocho capas que finalmente fue capaz de reconocer objetos de ImageNet con una precisión de nivel humano. Hinton formó una empresa con Krizhevsky y Sutskever y la vendió a Google. Él y Jackie compraron la isla en Georgian Bay: "mi único verdadero capricho", dijo Hinton |

Amo esta casa, pero a veces

es un lugar triste", dijo, mientras mirábamos las fotografías. "Porque a ella le encantaba estar aquí

y no está aquí". El sol casi se había puesto y Hinton encendió una pequeña luz sobre su escritorio. Cerró la computadora y se subió las gafas hasta la nariz. Se enderezó y volvió al presente. "Quería que supieras sobre Roz y Jackie porque son una parte importante de mi vida", dijo. "Pero, en realidad, también es bastante relevante para la inteligencia artificial. Hay dos enfoques para la IA. Hay negación y estoicismo. La primera reacción de todos ante la I.A. es 'Tenemos que detener esto'. Al igual que la primera reacción de todos ante el cáncer es: '¿Cómo vamos a eliminarlo?'". Pero era importante reconocer que eliminarlo era sólo una fantasía. Él suspiró. "No podemos negarlo", dijo. "Tenemos que ser reales. Necesitamos pensar: ¿Cómo podemos evitar que esto sea tan terrible para la humanidad como podría ser? ¿Qué tan útil (o peligrosa) será la I.A. resulta ser? Nadie lo sabe con certeza, en parte porque las redes neuronales son muy extrañas. En el siglo XX, muchos investigadores quisieron construir computadoras que imitaran los cerebros. Pero, aunque las redes neuronales como los modelos GPT de OpenAI son similares a los cerebros en el sentido de que involucran miles de millones de neuronas artificiales, en realidad son profundamente diferentes de los cerebros biológicos. Las IA actuales están basadas en la nube y alojadas en centros de datos que utilizan energía a escala industrial. Desorientados en algunos aspectos y sabios en otros, razonan ante millones de usuarios, pero sólo cuando se les solicita. No están vivos. Probablemente hayan pasado la prueba de Turing, el estándar largamente anunciado, establecido por el pionero de la informática Alan Turing, que sostenía que se podía decir, razonablemente, que cualquier computadora que pudiera imitar persuasivamente a un ser humano en una conversación pensaba. Y, sin embargo, nuestras intuiciones pueden decirnos que nada de lo que reside en una pestaña del navegador podría realmente pensar de la forma en que lo hacemos. Los sistemas nos obligan a preguntarnos si nuestro modo de pensar es el único que cuenta. Durante sus últimos años en Google, Hinton centró sus esfuerzos en crear una inteligencia artificial más tradicional, similar a la mente, utilizando hardware que emulaba más fielmente al cerebro. En las IA actuales, los pesos de las conexiones entre las neuronas artificiales se almacenan numéricamente; es como si el cerebro mantuviera registros sobre sí mismo. Sin embargo, en su cerebro analógico real, los pesos están integrados en las conexiones físicas entre las neuronas. Hinton trabajó para crear una versión artificial de este sistema utilizando chips de computadora especializados. "Si pudieras hacerlo, sería increíble", me dijo. Los chips podrían aprender variando sus "conductancias". Como los pesos estarían integrados en el hardware, sería imposible copiarlos de una máquina a otra; cada inteligencia artificial tendría que aprender por sí sola. "Tendrían que ir a la escuela", dijo. "Pero se pasaría de utilizar un megavatio a treinta vatios". Mientras hablaba, se inclinó hacia adelante, sus ojos taladrando los míos; Pude vislumbrar a Hinton el evangelista. Porque el conocimiento adquirido por cada A.I. se perdería cuando fuera desmontado, llamó a este enfoque "computación mortal". "Renunciaríamos a la inmortalidad", dijo. "En literatura renuncias a ser un dios por la mujer que amas, ¿no? En este caso, obtendríamos algo mucho más importante: la eficiencia energética". Entre otras cosas, la eficiencia energética fomenta la individualidad: como un cerebro humano puede funcionar con avena, el mundo puede sustentar miles de millones de cerebros, todos diferentes. Y cada cerebro puede aprender continuamente, en lugar de ser entrenado una vez y luego lanzado al mundo. Como empresa científica, la mortal A.I. podría acercarnos a replicar nuestros propios cerebros. Pero Hinton ha llegado a pensar, lamentablemente, que la inteligencia digital podría ser más poderosa. En la inteligencia analógica, "si el cerebro muere, el conocimiento muere", afirmó. Por el contrario, en la inteligencia digital, "si una computadora en particular muere, esas mismas conexiones pueden usarse en otra computadora. E, incluso si todas las computadoras digitales murieran, si hubiera almacenado las intensidades de conexión en algún lugar, podría simplemente crear otra computadora digital y ejecutar los mismos pesos en esa otra computadora digital. Diez mil redes neuronales pueden aprender diez mil cosas diferentes al mismo tiempo y luego compartir lo que han aprendido". Esta combinación de inmortalidad y replicabilidad, afirma, sugiere que "deberíamos preocuparnos de que la inteligencia digital reemplace a la inteligencia biológica". ¿Cómo

deberíamos describir la vida mental de una inteligencia digital sin un cuerpo mortal ni una identidad individual? En

los últimos meses, algunos A.I. Los investigadores han empezado a llamar a GPT un "motor de razonamiento",

una forma, tal vez, de liberarse del peso de la palabra "pensamiento", que nos cuesta definir. "La gente nos

culpa por usar esas palabras: 'pensar', 'saber', 'comprender', 'decidir', etc.", me dijo Bengio. "Pero aunque no

comprendamos completamente el significado de esas palabras, han sido formas muy poderosas de crear analogías que nos

ayudan a comprender lo que estamos haciendo. Nos ha ayudado mucho hablar de "imaginación", "atención",

"planificación", "intuición" como herramienta para aclarar y explorar". En opinión

de Bengio, "mucho de lo que hemos estado haciendo es resolver el aspecto 'intuición' de la mente". Las intuiciones

pueden entenderse como pensamientos que no podemos explicar: nuestra mente las genera para nosotros, inconscientemente, al

establecer conexiones entre lo que encontramos en el presente y nuestras experiencias pasadas. Tendemos a valorar la razón

más que la intuición, pero Hinton cree que somos más intuitivos de lo que reconocemos. "Durante

años, la IA simbólica. La gente decía que nuestra verdadera naturaleza es que somos máquinas de

razonamiento", me dijo. "Creo que eso es simplemente una tontería. Nuestra verdadera naturaleza es que somos

máquinas de analogías, con un poco de razonamiento incorporado, para notar cuando las analogías nos dan

respuestas incorrectas y corregirlas". |

|

Hinton continuó explorando estas ideas, primero en la Universidad de California, San Diego, donde realizó un posdoctorado (y se casó con Joanne, a quien dio clases de visión por computadora); luego en Cambridge, donde trabajó como investigador en psicología aplicada; y luego en Carnegie Mellon, en Pittsburgh, donde se convirtió en profesor de informática en 1982. Allí gastó gran parte de su presupuesto de investigación en una única computadora lo suficientemente potente como para ejecutar una red neuronal. Pronto se casó por segunda vez con Rosalind Zalin, una bióloga molecular. En Carnegie Mellon, Hinton logró un gran avance. Trabajando con Terrence Sejnowski, informático y neurocientífico, produjo una red neuronal llamada Máquina Boltzmann. El sistema recibió su nombre de Ludwig Boltzmann, el físico austriaco del siglo XIX que describió, matemáticamente, cómo el comportamiento a gran escala de los gases se relacionaba con el comportamiento a pequeña escala de sus partículas constituyentes. Hinton y Sejnowski combinaron estas ecuaciones con una teoría del aprendizaje. |

UN FINAL PERFECTO

U A UNA DISERTACION FASCINANTE.,

Bajamos por el sendero boscoso,

pasamos los cobertizos y descendimos por las escaleras hasta el muelle, luego subimos al bote de Hinton. Era un día

azul perfecto, con un fuerte viento que agitaba el agua. Hinton estaba al volante. Me senté al frente, viendo pasar

otras islas, pensando en la historia de A.I. Para algunos, es un cuento copernicano, en el que nuestras intuiciones sobre

el carácter especial de la mente humana están siendo desalojadas por máquinas pensantes. Para otros,

es prometeico: habiendo robado el fuego, corremos el riesgo de quemarnos. Algunas personas piensan que nos estamos engañando

a nosotros mismos, dejándonos engañar por nuestras propias máquinas y las empresas que esperan sacar

provecho de ellas. Curiosamente, también podría tratarse de una historia sobre las limitaciones humanas. Si

fuéramos dioses, podríamos crear un tipo diferente de IA; en realidad, esta versión fue la que pudimos

manejar. Mientras tanto, no pude evitar considerar la historia desde una perspectiva edénica. Al intentar recrear los

sistemas de conocimiento en nuestras cabezas, nos habíamos apoderado de la manzana prohibida; ahora nos arriesgábamos

al exilio de nuestro mundo encantado. Pero ¿quién elegiría no saber cómo funciona el conocimiento? En el puerto Hinton hizo un buen trabajo trabajando con

el viento, acelerando hacia adelante, girando y luego permitiendo que lo guiara hacia su embarcadero. "Estoy aprendiendo",

dijo, orgulloso de sí mismo. Caminamos hasta tierra y esperamos junto a una tienda a que llegara Rosemary. Después

de un rato, Hinton entró a comprar una bombilla. Me puse de pie, disfrutando del calor, y luego vi a una mujer alta,

de ojos brillantes y largo cabello blanco, que caminaba hacia mí desde el estacionamiento.Rosemary y yo nos dimos la

mano. Luego miró por encima de mi hombro. Hinton estaba emergiendo de la vegetación cercana a la tienda, sonriendo.

|